Por Abogada Liliana Pizarro Martinefsky* –

Por Abogada Liliana Pizarro Martinefsky* –

Europa ya cuenta con el primer marco jurídico sobre Inteligencia Artificial (IA), consolidando así su liderazgo mundial en la materia. El 9 de diciembre de 2023, el Parlamento Europeo y el Consejo alcanzaron un acuerdo político sobre esta Ley que se encontrará vigente desde su publicación en el Diario Oficial de la UE.

El objetivo principal se centra en la definición de estándares de seguridad y derechos fundamentales para evitar que esta tecnología sea utilizada con fines ilícitos, discriminatorios o de manipulación, así como fomentar y garantizar una IA fiable en Europa que respeten los principios éticos. Es un marco regulatorio que forma parte de un paquete de IA más amplio, que incluye el Plan Coordinado actualizado sobre IA. Ambos están orientados a garantizar y proteger la seguridad y los derechos fundamentales de los ciudadanos y ciudadanas europeas así como a las empresas fortaleciendo la inversión e innovación en toda la Unión Europea.

Esta Ley se aplicará a la IA de uso general, es decir a la conocida como modelos básicos o IA generativa avanzada. Se trata de sistemas que pueden realizar una amplia gama de funciones y adaptarse a diferentes tareas.

Tanto los usuarios, desarrolladores como los implementadores de estos sistemas de IA deberán cumplir los requisitos y obligaciones establecidos en el marco regulatorio que, al mismo tiempo, pretende reducir las cargas administrativas y financieras para las empresas, en particular las pequeñas y medianas empresas (PYME).

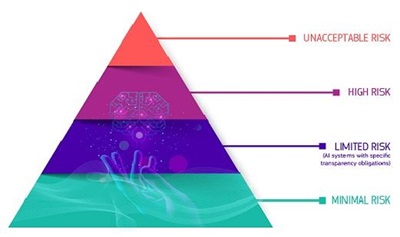

Para ello, se crean cuatro categorías basadas en el riesgo:

Riesgo inasumible: Se prohibirán todos los sistemas de IA que se consideren una clara amenaza para la seguridad, los medios de vida y los derechos de las personas, desde la puntuación social de los gobiernos hasta los juguetes que utilizan asistencia de voz y fomentan comportamientos peligrosos.

Alto riesgo: Los sistemas identificados como de alto riesgo incluyen la tecnología de IA utilizada en:

- infraestructuras críticas (por ejemplo, transporte), que podrían poner en riesgo la vida y la salud de los ciudadanos;

- formación educativa o profesional, que puede determinar el acceso a la educación y el curso profesional de la vida de una persona (por ejemplo, puntuación de exámenes);

- componentes de seguridad de los productos (por ejemplo, aplicación de IA en cirugía asistida por robot);

- empleo, gestión de trabajadores y acceso al autoempleo (por ejemplo, software de clasificación de CV para procedimientos de contratación);

- servicios públicos y privados esenciales (por ejemplo, calificación crediticia que niega a los ciudadanos la oportunidad de obtener un préstamo);

- aplicación de la ley que pueda interferir con los derechos fundamentales de las personas (por ejemplo, evaluación de la confiabilidad de las pruebas);

- gestión de la migración, el asilo y el control de fronteras (por ejemplo, verificación de la autenticidad de los documentos de viaje);

- administración de justicia y procesos democráticos (por ejemplo, aplicación de la ley a un conjunto concreto de hechos).

Los sistemas de IA de alto riesgo estarán sujetos a obligaciones estrictas antes de poder comercializarse:

- sistemas adecuados de evaluación y mitigación de riesgos;

- alta calidad de los conjuntos de datos que alimentan el sistema para minimizar los riesgos y los resultados discriminatorios;

- registro de actividad para garantizar la trazabilidad de los resultados;

- documentación detallada que proporcione toda la información necesaria sobre el sistema y su propósito para que las autoridades evalúen su cumplimiento;

- información clara y adecuada al usuario;

- medidas apropiadas de supervisión humana para minimizar el riesgo;

- alto nivel de robustez, seguridad y precisión.

En cuanto a los sistemas de identificación biométrica remota se consideran de alto riesgo y están sujetos a requisitos estrictos. El uso de este tipo de identificación en espacios de acceso público con fines policiales, en principio, está prohibido. En casos excepcionales, como cuando es necesario buscar a un niño desaparecido, prevenir una amenaza terrorista específica e inminente o detectar, localizar, identificar o procesar a un autor o sospechoso de un delito grave, dichos usos están sujetos a la autorización de un organismo judicial u otro organismo independiente y a límites apropiados en el tiempo, el alcance geográfico y las bases de datos buscadas.

Riesgo limitado: El riesgo limitado se refiere a sistemas de IA con obligaciones específicas de transparencia. Al utilizar sistemas de inteligencia artificial como los chatbots, los usuarios deben ser conscientes de que están interactuando con una máquina para poder tomar una decisión informada de continuar o dar un paso atrás.

Riesgo mínimo o nulo: La ley de IA permite el uso gratuito de IA de riesgo mínimo. Esto incluye aplicaciones como videojuegos con IA o filtros de spam. La gran mayoría de los sistemas de IA que se utilizan actualmente en Europa entran en esta categoría.

Es indispensable, por las razones expresadas, proporcionar una regulación normativa para el uso de estos sistemas inteligentes y minimizar o evitar que se produzcan ciertos riesgos. A modo de ejemplo, con frecuencia no es posible descubrir por qué un sistema de IA tomó una decisión o predicción y realizó una acción particular. En consecuencia, puede resultar difícil evaluar si alguien ha sido perjudicado injustamente, como en una decisión de contratación o en una solicitud para un plan de beneficios públicos. Si bien la mayoría de los sistemas de IA plantean riesgos limitados o nulos, los europeos necesitan confiar en lo que la IA tiene para ofrecer. Es por ello que, en el caso de los proveedores de sistemas de alto riesgo, una vez que el sistema de IA está en el mercado, las autoridades están a cargo de la vigilancia del mercado, los usuarios garantizan la supervisión y el seguimiento humanos, y los proveedores cuentan con un sistema de seguimiento posterior a la comercialización. Los proveedores y usuarios también comunicarán incidencias graves y mal funcionamiento.

Por último, dada la complejidad y el alto tecnicismo de la materia regulada hay que tener en cuenta que se trata de una tecnología que evoluciona rápidamente y sus aplicaciones deberían seguir siendo fiables incluso después de haber sido comercializadas. Esto justifica la necesidad de un gestión continua de la calidad y los riesgos por parte de los proveedores y una legislación activa y renovada que permita una protección eficaz frente a los nuevos desafíos que puedan plantear el uso de los sistemas de IA.

Fuente:AI Act | Shaping Europe’s digital future

*Colaboración Especial desde España para En Provincia – alimotxe54@gmail.com

Fotografías: https://pixabay.com/